Óriási a felhajtás a mesterséges intelligencia körül, sokaknál emiatt alakult ki már most egyfajta ellenszenv az egész téma kapcsán. Mindegy, miről van szó pontosan, mire lehet képes és miképp érdemes használni, a reklámokból, hírekből áramló üzenetekből leginkább az látszik, hogy ez az egész megint csak egy újabb lehetőség a cégeknek arra, hogy extra vásárlást, szükségtelen fogyasztást generáljanak. Ez az álláspont érthető és védhető pont amiatt, hogy nagyon keveset tudni arról, mi is ez pontosan. Mitől lesz mesterséges intelligencia egy laptopban? Miért jó, ha egy játékra kihegyezett asztali gépben benne van, és úgy egyáltalán: mit kell megtanulni ahhoz, hogy értsd a működését és tudd alkalmazni hétköznapjaidban?

Sok a homályos rész, szerintünk szándékosan, illetve amikor szó esik arról, hogy egy új AI funkciót tesznek az adott szoftverbe vagy hardverképességek közé, akkor csak nagyon érintőlegesek és felszínesek az erre vonatkozó számadatok. Megítélhetjük úgy is, hogy bár korszakváltás előtt állunk, ez inkább csak egy újabb fogyasztói lépcsőfok, ami meglévő eszközeink leváltására buzdít.

Az AI megint(!) itt van

Bár nem a PC-kategóriába sorolható, de a dél-koreai Samsung új csúcstelefonjainak bejelentéséhez alkotott szlogen azt sugallja, hogy most jött el a mesterséges intelligencia ideje, és a Samsung mobilok az elsők között vannak, hogy ezt megmutassák. Jól hangzik, pedig valójában az elképzelés, hogy a mindennapi használatban lévő eszközökben legyenek speciális számításokat, feladatokat végző hardverek, egyáltalán nem új keletű gondolat. Sőt, számtalan próbálkozás és piaci termék jelent meg az elmúlt két évtizedben, amelyek tulajdonképpen már alkalmazták azokat a módszertanokat és architektúrákat, amelyeket ma forradalmi újításként igyekeznek eladni.

Ha csak a PC-ket nézzük, a grafikus vezérlők felépítésének átalakulása az általános célú felhasználások irányába vehető egyfajta általános mérföldkőnek, sőt már ezelőtt is számtalan dedikált, egy-egy funkciót gyorsító ASIC-hardver is létezett. A párhuzamosítás és a bonyolultabb matematikai műveletvégzés, illetve maga a gépi tanulás cseppet sem új, mint ahogy a felhasználó és gép közti kommunikáció és interakció sem most válik elképesztően életszerűvé. Nem kell sci-fit nézni ehhez, az AI-ról évek óta beszélnek, itt-ott megjelenik, majd eltűnik; alapvetően azért, mert az adott termék, amiben megbújik, nem ér el kereskedelmi értelemben vett sikereket.

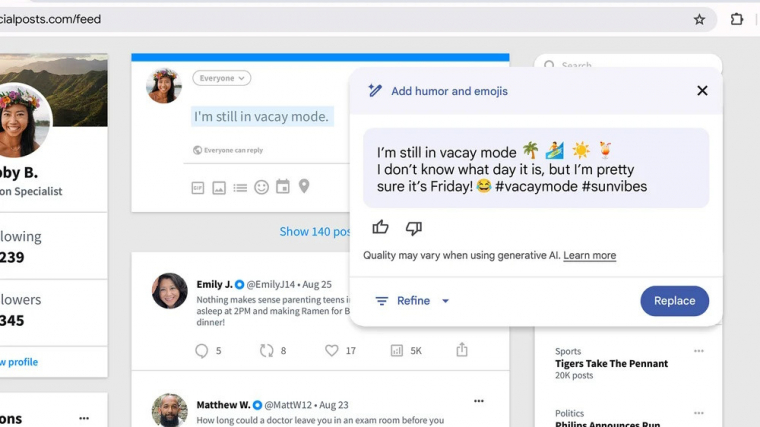

2024 azonban ígéretesen indul, úgy tűnik, hogy a teljes iparág erre tett fel mindent, avagy a felhasználók most tényleg kénytelenek megismerkedni a mesterséges intelligenciával, legyen az chatbot, böngészőbe épített kereső, audiovizuális segédeszköz vagy tartalomgyártásra hangolt segéd. Még mi sem vagyunk biztosak abban, hogyan kellene/illene nevezni, így nem meglepő, ha zúdulnak ránk a márkanevek: Copilot, Gemini, Duet AI, Ryzen AI és még sorolhatnánk. Örüljünk, hogy itt van(nak), de azért érdemes óvatosan elmerülni ebben a tengerben.

A Microsoft most tényleg berobbantja a PC-piacot

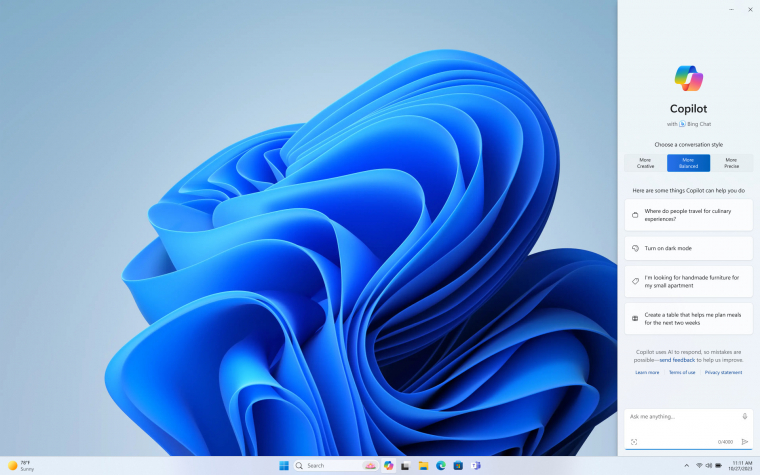

A Microsoft Windows főverzióinak bevezetése általában megdobja a PC-eladásokat, de amikor ezen túl merészkedett a redmondi óriás, akkor a végeredmény mérsékelt siker vagy érdektelenség lett. A Windows 11 kontra 12 kapcsán a sajtóban már most nagy a bizonytalanság, amit a Copilot megjelenésével szinte teljesen sikerült háttérbe szorítani. Annyira nagynak tűnik a lendület a szoftveróriás részéről, hogy a hardvergyártók is követik a Microsoftot, avagy majdnem mindennel kapcsolatban felmerül az "AI", mint hívószó, és a közeljövő termékfejlesztéseinél a mesterséges intelligencia támogatása immáron fő szemponttá vált. Új processzorok, videokártyák, kijelzők jönnek és mennek, de mindenki a mesterséges intelligenciát emlegeti, még olyan értelemben is, amire csak erőltetetten lehet ráhúzni.

Az első lényeges elem a megértéshez mindenképp az legyen, hogy a tudás egy része a felhőből érkezik, adatközpontokban elhelyezett nagy teljesítményű szerverek számolnak, a végeredmény pedig milliszekundumok alatt a laptop kijelzőjére kerül. Egy másik alkalmazáshalmazban valóban az eszközbe szerelt AI-hardverre van szükség, és ekkor tényleg nem mindegy, hogy milyen gyorsan számol a gép, de a gyorsított funkciók javát nem biztos, hogy a többség értékelni fogja. Ezek nem látványos cselekmények, inkább csak extra lehetőségek arra, hogy gyorsabban, szebben, tisztábban, jobban fusson le egy feladat.

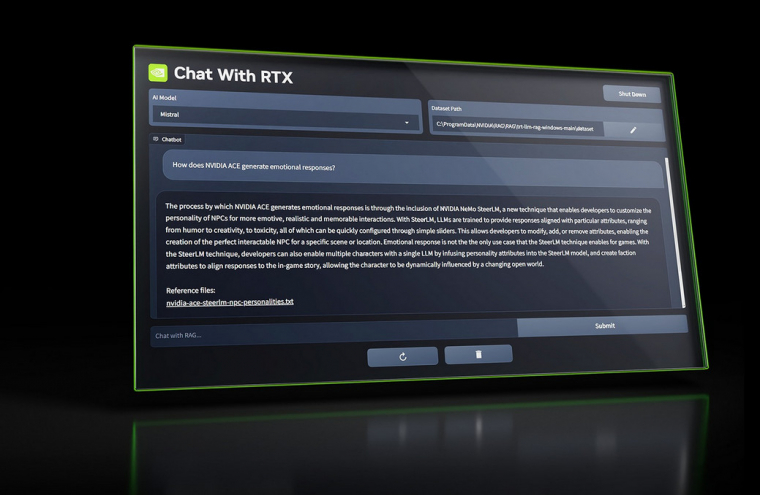

A Copilot kapcsán például egyelőre mindenki azt találgatja, hogy valóban hasznos lesz-e az a sokrétű tudás, amit megmutattak. Megbeszélések audiosávjából jegyzetkészítés, majd rövid összegzés másodpercek alatt? Prezentáció stílusának, kinézetének megalkotása pár kattintással? Szövegírás, képgenerálás kvázi ingyen? Estig sorolhatnánk az ígéreteket, amik egytől-egyig izgalmasak, most már csak az a kérdés, hogy miért van szükség minimum 16 GB memóriára ahhoz, hogy "AI Ready" legyen egy PC.

Processzorban az erő

A Las Vegas-i CES-en szinte nem volt olyan notebook vagy asztali PC, amibe olyan processzor került volna, ami ne tartalmazna valamilyen NPU (Neural Processing Unit) egységet. A gyártók versenyt futnak egymással, hogy ki tudja hamarabb elárasztani a piacot a saját fejlesztéseivel, és egyértelműen arra buzdítanak, hogy mihamarabb vásároljunk az új gépekből. Az AMD egyik korábbi bemutatójába bekerült egy olyan dia, ami a Ryzen AI szoftveroldali támogatottságát mutatta be. Legalább 50 program kezeli az XDNA-architektúrára épülő részegységet, a gyorsított funkciók között azonban egyelőre csak multimédiás finomságok szerepeltek (pl. képmanipulálás, képgenerálás, intelligens szűrőhasználat stb.).

Nem olyan meglepő a lista, itt tartunk jelenleg. Ennek viszont már van saját történelme, hiszen az Intel 6-7 évvel ezelőtt a Movidius projekt részeként kreált VPU-kal (Vision Processing Unit) kifejezetten a képminőség feljavítását és filterezését gyorsította. Gyorsan hozzá kell tenni, hogy nem saját fejlesztésről van szó, a Myriad VPU-projekt felvásárlásával került ez a tudás az óriásvállalathoz. A Core Ultra mobil processzorokban található NPU is innen ered, a gyártástechnológia fejlődése tette lehetővé a CPU-tokozáson belüli integrációt, és az AI-lökést valószínűleg emiatt érzik most erősebben a gyártók. Benne van a processzorban, nincs kiegészítő kártya vagy periféria, a mesterséges intelligencia által elvárt számításokhoz azonnal bevethető.

Érdekességképp jegyezzük azért meg, hogy a hagyományos PC-kategóriában a Qualcomm volt az első vállalat, amely integrált NPU-val jelentkezett, épp a Microsofttal közösen. A Surface Pro 9 5G-s verziójában található SQ3 rendszerlapka az első, ami integráltan nyújt NPU-képességeket, nagy kár, hogy az ARM-architektúra miatt az alapműködés sebességével és kompatibilitásával problémák vannak. Érdemes visszaemlékezni az Apple azon lépésére is, amikor leállította az Intel processzorok használatát, és a saját fejlesztésű M1 lapka első verziós NPU-ja tett igazán különbséget a régi és az új MacOS funkciók között.

Érdemes gépet cserélni az AI miatt?

A csapból is az folyik, hogy igen, hiszen a felhasználói élményt alaposan megdobhatja, ez pedig előremutató és jó a felhasználónak; és akkor most ideje felébredni a mesterséges intelligencia által generált álomvilágból. Semmi olyan nem történik egyelőre, amit ne láttunk volna korábban a PC-piacon: hiába az AI, a konkrét vásárlásnak tudatosnak és lehetőleg észszerűnek kell lennie. A hardveres paraméterek ismertek, bár az ezeken szereplő TOPS-értékekre (billió művelet másodpercenként) nehéz mit mondani, különösen semmitmondó az elődökhöz képest mért sokszoros (akár 14×-es) fejlődés.

A már említett, egyelőre hivatalosan nem megerősített 16 GB-os rendszermemória-követelmény egyébként kedvező előrelépés, bár ennek valós hatásait majd csak évek múltán láthatjuk a jelenleg még 4 GB RAM-on szenvedő alsó kategóriában. A jelenleg kínált platformok közül az AMD-é most felkészültebbnek tűnik, és a Ryzen 8000-es sorozatának összes tagja rendelkezik AI-egységgel, míg az Intelnél a felemásra sikerült Core Ultra mutatja magát lehetséges alternatívaként, de kizárólag laptopokban. Az asztali termékkörre még várni kell, ami talán nem is baj, mert bár a Copilot funkciók egyre szélesebb körben elérhetők - előfizetéses konstrukcióban akár egy kisvállalat számára is -, időbe telik, mire a felhasználók hozzászoknak az új irányhoz. Ami azzal kezdődik, hogy a Copilot az operációs rendszerrel együtt indul, a Windows asztalnak vagy tálcának szerves része, és majd' minden művelethez van némi hozzáfűzni valója.

Az árakat illetően egyelőre nem érezni, hogy drágulást eredményezne a technológia, és ez vélhetően így is marad. Nincs értelme számszerűsíteni az árcédulán ezt a tudást, ha a minél gyorsabb elterjedés és alkalmazhatóság a cél. Ha van is különbség, a megszokott "újdonság ereje" dominál, a korábbi modellek kifutásával normalizálódni fognak az árak.

Windowson túli izgalmak

Hiába a saját processzordizájn és az erre épülő termékcsalád, viszonylag keveset hallani arról, hogy a Macbookokra évente érkező rendszerfrissítések miként használják a lapkákba integrált NPU-t. Vagyis bizonyos képi funkciók támogatása egy ideje elérhető, de akkora horderejű AI-csomag, mint amit mások bevezetnek, egyelőre nincs porondon az Apple-nél. Mindez változhat az idei WWDC-n, mint ahogy a Linux-disztribúciókat használóknak sem kell azt érezniük, hogy kimaradnak valami fontos technológiából. A különféle gépi tanulást segítő keretrendszerek (PyTorch, TensorFlow stb.) bárki számára elérhetők disztribúciótól függetlenül, és a folyamatosan, kernelszinten bővülő hardvertámogatás miatt viszonylag gyorsan naprakészre fordíthatók. Érdemes egy próbát tenni, teljesen más az AI-élmény, mint Windowson, igaz, több utánajárást igényel az alkalmazások megfelelő telepítése.

Nincs tehát kivétel, mindenki ugyanarra tart, csak más utakon, eltérő módon megszólítva a felhasználókat. Bölcs dolog kivárni, mi történik az év második felében, mert egyelőre az ígéretekkel már tele a padlás, jó lenne átélni a tényleges felhasználói előnyöket, mielőtt végső döntést hozunk, hogy melyik AI-t és milyen szinten engedjük be mindennapjainkba.