Az Apple még augusztusban jelentette be, hogy készítenek egy algoritmust (CSAM), ami folyamatosan elemzi majd a felhasználók fotóit az iCloudban és a lokális eszközökön, hogy gyermekekre veszélyes tartalmakat keressen.

Ez már magában is elég gyanúsan hangzik, ha pedig belevonjuk a képletbe, hogy elégséges egyezés esetén emberi ellenőrzés is sorra került volna, majd a hatóságok bevonása, érthető, hogy miért verte ki a hír a biztosítékot rengeteg felhasználónál. Az egészen biztos volt, hogy ebben a formában nem fog működni a rendszer, az Apple azonban kitartott és még azt is elárulták, hogy egy hasonló megoldással már 3 éve ellenőrzik a felhasználóik e-mail váltásait. Jó tudni.

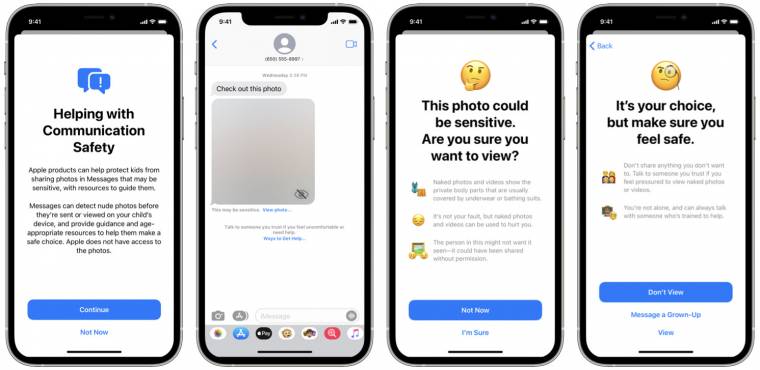

A nagy felháborodás végül, ugyan csak részben, de elérte a célját. Az Apple meghátrált és egy sokkal finomabb módszert dolgozott ki a gyermekek védelmében. Ennek a lényege, hogy amikor a telefon, vagy tablet érzékeny fotót talál, azt kihomályosítja és az alábbi üzeneteket jeleníti meg a küldőnek, vagy épp a fogadónak:

Ezt a pajzsot már nagyon át akarta ütni az Apple és elvileg az iOS 15.2-es élesíteniük is kellett volna, ehelyett azonban 180 fokos fordulatot vettek a fejlesztők.

Történt ugyanis, hogy a frissítés után sem vált elérhetővé a szülőknek a funkció bekapcsolása, az Apple pedig szép csendben eltüntetett minden támogató oldalt, ami a CSAM-mel foglalkozott. A The Verge fel is kereste ezzel kapcsolatban az céget, amire Shane Bauer, az Apple szóvivője elárulta, a cég számára kritikus fontosságú mechanika továbbra is formálódik, a szeptemberi tervektől nem tértek el, szóval a képek szűrésére létrehozott algoritmus továbbra is tervben van az Apple eszközökre.

Szerintetek van bármilyen elfogadható módja egy ilyen algoritmus implementálására? Ha igen, hogyan garantálható, hogy a képek vizsgálata tényleg lokálisan történik? Még mindig sok a kérdőjel, amikre jó lenne választ kapni, mielőtt újra nekifut a témának az Apple.