Mindig is a számítástechnikai alapfogalmak közé tartozott az adattárolás, amelynek bármily bonyolult is megismerni a módját, minőségét és technológiai fejlettségét, egyre többen tesznek ez irányba lépéseket. Vajon miképp keletkeznek azok a fránya bitek, byte-ok a mindennapi használat során, és ezeket mi képes "megjegyezni"? A tanulási görbe ezúttal is az olyan, egyszerűen befogadható jelzőktől indul, mint a gyorsaság, az alacsony időzítés és a fogyasztás, ezek mentén a témát szép lassan kibontva juthatsz el a NAND-cellák tulajdonságaihoz vagy épp az adatkapcsolatokra jellemző szabványokhoz.

Akit érdekel az SSD-k működési háttere, valószínűleg izgalmasabb és érdekesebb világba léphet be, mint amilyet a merevlemez kapcsán ismerhetett meg.

Az adott fordulatszámon pörgő tányérok és a felettük lebegő olvasófejek működése sem mindennapi, de ami a memóriacellákon alapuló tárhelyeknél kialakult, szinte végtelen lehetőségek jövőjét tárja a szemed elé. Ember legyen a talpán, aki akár a külső borítást lebontva megmondja, hogy az adott meghajtó hogyan működik, és bizonyos programhasználat esetén milyen teljesítményre és megbízhatóságra lesz képes. A nyomtatott áramköri lapokat látva chipek sokasága kacsint vissza, az elrendezés pedáns, és leginkább az juthat az eszedbe, hogy ebből hogyan lesz egyáltalán futó operációs rendszer és programok, miképp van az, hogy adatok terabyte-jai férnek el az névjegykártyánál is kisebb lapocskán.

Cellák, blokkok mindenfelé

Talán a mai napig az egyik legfontosabb kérdés és egyben összevetési faktor a HDD-kkel a tárolható adatok nagysága és mennyisége. A merevlemezek kapcsán megszokhattad, hogy terabyte-os léptékekkel tervezhetsz, a gyártók ráadásul igen előremutató technológiákat vetnek be a tányérok adatsűrűsége és -rögzítése terén. Valami ilyesmi történik egy ideje az SSD-k frontján is, csak épp nem a tányérok számát, kapacitásbeli terhelhetőségét kell alapul venni, hanem a felhasznált NAND-lapkákra vonatkozó bitsűrűséget.

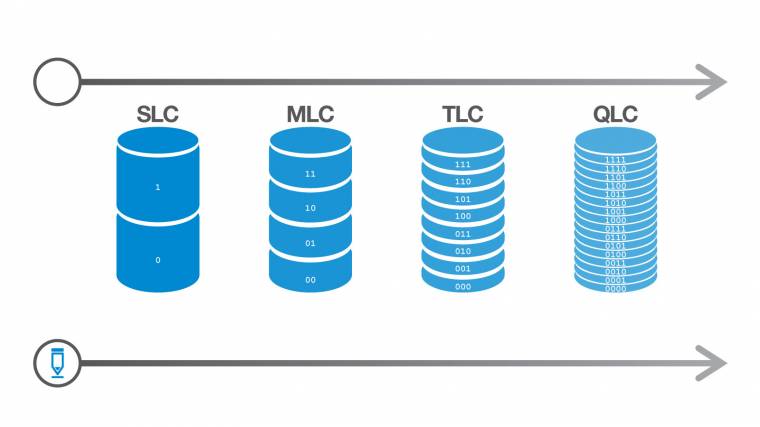

A gyártók számára nyilvánvalóan az a "jó" termék, amely minél több adatot képes úgy tárolni, hogy az előállítási költség és a memóriachipek élettartama optimális legyen. Az SLC (Single-Level Cell) és az MLC (Multi-Level Cell) cellafelépítésű meghajtók annak idején két lehetséges utat vázoltak a felhasználók számára: ha magas olvasási és írási sebességre van szükséged, akkor válaszd az előbbit, ha a nagyobb adatsűrűségből adódóan kedvezőbb áron kínált nagyobb tárhelyre, akkor utóbbit. A valóság persze ennél azért árnyaltabb volt, hiszen a puffertárak és a vezérlők közötti működési eltérések is befolyásolják a meghajtó működési jellemzőit, de tény, hogy az SLC-alapú példányok vitték a prímet.

A TLC (Triple-Level Cell) és a QLC (Quad-Level Cell) NAND-technológiák szépen követik a fejlődési görbét, és háromszor vagy épp négyszer annyi bitet tárolnak egy memóriacellában a kezdeti 1-2 bites integráltsághoz képest. A hátrány, hogy az olvasási és írási folyamatok lassuló tendenciát mutatnak, ráadásul egyre kifinomultabb feszültségszabályzás szükséges az adott lapka, blokk vagy épp cella működtetéséhez használat közben. Nagy szerencséje a teljes iparágnak, hogy a TLC és QLC-alapú meghajtók piacra kerülésekor szárnyra kapó tévhitek végül nem bizonyultak igaznak. A megfelelően kivitelezett tápellátás, adatforgalmazási protokoll és gyorsítótárazás triója megbízhatóvá és sebessé varázsolta az újdonságokat. Az MLC-öröksége még itt-ott jelen van, de a csökkenő tárkapacitás-költség arány érdekében felhizlalt összkapacitás csak jót tett a hétköznapi PC-knek.

Gyorsítótárakkal lassíthatsz

Nagyon leegyszerűsítve, az SSD-k nyomtatott áramkörén található NAND-lapkák olvasási és írási sebességét a vezérlő mellett kialakított gyorsítótárazás növeli. Természetesen maga a vezérlő a parancssorkezeléssel, egyre szélesebb adatsávú, párhuzamosított működésével is kellő löketet adhat az adatok tárolására és/vagy kinyerésére, de az ideiglenes tárként funkcionáló pufferek vetítik a szemünk elé a mára akár 10 GB/másodperc feletti értékeket. A gyártók alapvetően kétféle gyorsítótárazási elképzelés mellett haladnak az utóbbi években; a különbséget az ő szempontjuk szerint továbbra is a költséghatékonyság jelenti.

Felhasználói oldalról nézve a klasszikus történetet olvashatod, avagy minél magasabb ársávból választasz meghajtót, annál biztosabb a dedikált DRAM-cache megléte.

Ez egy nagyon gyors átmeneti tár, ami akár 8 GB méretű is lehet, és roppant gyorssá teszi az olvasási/írási folyamatokat, miközben nem használ fel egyetlen egy memóriacellát sem a tárkapacitásból. Ezzel szemben az SLC-gyorsítótár nem egy külön lapka, hanem a TLC vagy QLC NAND-memória egy leosztott része, ami kvázi SLC-szerűen működik, avagy csak egy bitnyi adatot tárol cellánként, amivel gyorsítható az olvasás és az írás is. Az egyetlen gond ezzel az, hogy amint elkezd betelni a meghajtó, akár drasztikusan is visszaeshet az adatforgalmazási sebesség. A cache mérete ugyanis jóval nagyobb, a teljes meghajtókapacitástól függően akár 100 GB-os is lehet, nyilvánvalóan nagyon nem mindegy, hogy az olvasás és írás során erről a területről mikor "ürülhet ki" az adat. Egyes gyártók továbbmentek, és több részre bontják az SLC-puffert, a dedikált területet egy dinamikusan változó rész egészíti ki, sőt a merész mérnökök itt-ott teljesen különálló SLC-területet integrálnak QLC-s NAND-lapkák mellé; igaz, ekkor borítékolható a valamivel rosszabb költséghatékonyság.

Érdemes átnézned az egyes meghajtók specifikációit, de olykor még ez sem elég, és tovább kell keresned a választ a gyorsítótár kérdésére. Nagy baj akkor sincs, ha az olcsóbb szegmensből választasz, de készülj fel rá, hogy telített meghajtóállapotnál a lassulás hamar észlelhető lesz.

Melyik csatolófelületet?

Sokan csak csettintenek, hogy erre a legkönnyebb válaszolni, hiszen minden a PCI Expresst emlegeti, azt is valamilyen M.2 formában. Lehet ilyen felületes biztonsággal is vásárolni, de talán jobb rálátni az egyes szabványok és protokollok közti különbségre. Az SSD-k nagy hullámokat verő kezdeti terjedése még a SATA szabvány mentén történt, a PCI Express adatkommunikáció és az ezzel együtt megszülető NVMe protokoll igazodik leginkább a NAND-lapkák technológiai és működési elvárásaihoz. Gyors és hibatűrő adatkommunikáció, minél szélesebb párhuzamosítás és pufferkezelés - mind-mind eleme a legújabb NVMe-szabványnak, amely kereskedelmi szempontból épp az 1.3-as verziót használja, és találkozhatsz vele a legtöbb termék dobozán. Új konfigurációk esetében már csak ezek merülnek fel logikus lehetőségként, de régebbi PC-k fejlesztésekor mind a mai napig érdemes számolni a szabvány miatt legfeljebb elméleti 600 MB/s adatátvitellel rendelkező SATA-s tárolókkal. A fizikai méret a 2,5 inches kialakítástól az M.2 különböző mérethosszáig terjed, a konkrét azonosítószámok helyett érdemes az alaplap vagy a laptop kompatibilitási listáját ellenőrizned.

Egyre melegebb a helyzet

Említettük korábban a kifinomult feszültségkezelést, ami az egyre gyorsuló és növekvő tárkapacitású SSD-knél is fontos, ugyanakkor az akár 176 rétegű QLC-lapkák, a felpörgetett sebességű gyorsítótárak és az alkalmazott gyártástechnológiák kapcsán a melegedés problematikájával szinte biztosan találkozni fogsz. Jó hír, hogy az alaplapi bordákkal megfelelő mértékű a hőelvezetés, de tartósan hosszú terhelés során előfordulhat, hogy a gyárilag szerelt hűtőborda nélkül az SSD nem képes elérni az ígért teljesítményt. Az élettartamra (elvileg) nincs befolyással a melegebb környezet és üzem, mi mégis azt ajánljuk, hogy figyeld ezeket az értékeket. A meghajtók mellé járó segédprogramok képesek erre, de a rendszer-információs alkalmazások is tudják mérni a lapkák hőmérsékletét.

Még több hasonló cikket olvasnál? Vedd meg a 2022/12-es PC World magazint, ráadásul ajándék szoftvereket és PC-s teljes játékot is kapsz, ha így teszel!