Az NVIDIA bemutatta a második-generációs DGX Station A100 szerverét. Már az első modellnél sem aprózta el a dolgokat, a mostani változat nagy különlegességét pedig az új Ampere A100 Tensor Core GPU-k jelentik.

Persze ebből már ki lehetett találni, hogy nem otthoni felhasználásra készült a DGX Station A100, hanem azok számára, akik mesterséges intelligenciával, gépi tanulással és adattudományokkal foglalkoznak. Ami azt illeti, a gyártó szerint ez a leggyorsabb dobozos szerver, amit AI-kutatásra találtak ki.

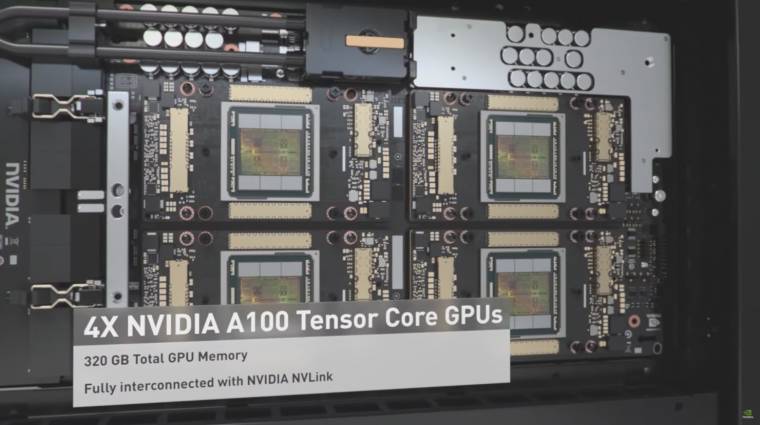

Belül akár 4 darab A100 Tensor Core GPU is helyet kaphat, így összesen 320 GB HBM2e memóriáról lehet beszélni. Ehhez pedig egy 64-magos, 128-szálas AMD EPYC GPU társul, maximum 512 GB rendszermemóriával és 7,68 TB tárhelyet kínáló NVMe M.2 SSD-kkel. Van harmadik-generációs NVLink, és karbantartást nem igénylő hűtési rendszer is.

Mire használják a nagyok az NVIDIA DGX Stationöket? A BMW Group Production például a működést fejlesztő MI-modellek fejlesztésére és telepítésére. A német DFKI társadalmi és ipari kihívások terén épít vele modelleket, és a gépi látás rendszereket alkalmazza a mentőegységek munkája során.

A Lockheed Martin MI-modelleket fejleszt, hogy megjósolja a karbantartási szükségleteket, ezzel növelje a gyártás hatékonyságát és a munkások biztonságát. Az NTT Docomo képfelismerés fejlesztésén dolgozik ezekkel, a Pacific Northwest National Laboratory pedig nemzetbiztonsági kutatásokat végez több témában is.